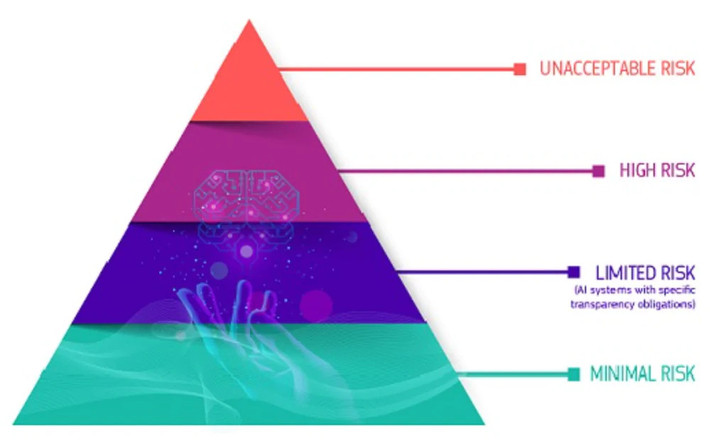

Quản lý AI dựa trên 4 cấp độ rủi ro

Trong quá trình soạn thảo Dự luật Trí tuệ nhân tạo (Dự luật AI), EU chú trọng đến nguyên tắc tập trung vào quyền của người dùng. Luật mới sẽ quản lý AI dựa trên 4 cấp độ rủi ro đối với người dùng.

Cách tiếp cận lấy người dùng làm trung tâm

Theo quan điểm của châu Âu, AI báo trước một sự chuyển đổi kỹ thuật số với tiềm năng đột phá đến mức không thể phó mặc cho ý thích bất chợt của các công ty công nghệ mà thay vào đó phải gắn chặt vào pháp quyền và quản trị. Trên thực tế, điều này có nghĩa là các chính phủ cần can thiệp để bảo vệ các quyền cơ bản của cá nhân, bảo tồn các cấu trúc xã hội và đảm bảo phân phối công bằng các lợi ích từ nền kinh tế kỹ thuật số.

Cách tiếp cận dựa trên quyền lợi đã được phản ánh trong các quy định đột phá của EU, chẳng hạn như Quy định Bảo vệ dữ liệu chung, bảo vệ quyền riêng tư dữ liệu của công dân. Gần đây, EU cũng đã thông qua Đạo luật Thị trường kỹ thuật số, áp đặt các nghĩa vụ đối với cái gọi là người gác cổng kỹ thuật số, bao gồm cả những gã khổng lồ công nghệ của Mỹ, để hạn chế sự thống trị của họ và bảo vệ sự cạnh tranh; và Đạo luật Dịch vụ kỹ thuật số, thiết lập các quy tắc giữ các nền tảng trực tuyến chịu trách nhiệm về nội dung mà chúng lưu trữ.

4 cấp độ rủi ro

Trên cơ sở phân biệt đó, luật mới của EU sẽ quản lý AI dựa trên mức đánh giá rủi ro (nguy cơ) đối với an ninh, an toàn của người dùng. Dự luật đưa ra 4 cấp độ rủi ro của AI bao gồm: rủi ro không thể chấp nhận được; rủi ro cao; rủi ro hạn chế; rủi ro tối thiểu hoặc không có rủi ro.

Rủi ro không thể chấp nhận được

Đúng như tên gọi, mức độ rủi ro này là không thể chấp nhận được trong quá trình phát triển và sử dụng các thuật toán AI. Ở những lĩnh vực này, việc sử dụng AI bị coi là mối đe dọa rõ ràng đối với an ninh, sinh kế và quyền của con người và sẽ bị cấm. Ví dụ, nó sẽ bị cấm sử dụng trong các hệ thống đánh giá xã hội, nhận dạng sinh trắc học thời gian thực hoặc thao túng tiềm thức.

Rủi ro cao

Các hệ thống AI được sử dụng trong các lĩnh vực sau đây được phân loại là có rủi ro cao: Cơ sở hạ tầng quan trọng (ví dụ: giao thông) có thể gây nguy hiểm đến tính mạng và sức khỏe của người dân; Đào tạo giáo dục hoặc dạy nghề, có thể xác định khả năng tiếp cận giáo dục và con đường nghề nghiệp của một người (ví dụ: điểm thi); Lĩnh vực y tế, chẳng hạn như trong phẫu thuật; Quản lý nhân sự (ví dụ: phần mềm phân loại hồ sơ xin việc cho quy trình tuyển dụng); Các dịch vụ tư nhân và công cộng cơ bản (ví dụ: đánh giá mức độ tín nhiệm); Các hành động thực thi pháp luật có thể hạn chế các quyền cơ bản của mọi người đối với công lý (ví dụ: đánh giá độ tin cậy của bằng chứng); Quản lý di cư, tị nạn và kiểm soát biên giới (ví dụ: chứng thực giấy tờ đi lại); Quản lý công lý và các quy trình dân chủ (ví dụ: áp dụng luật cho một tập hợp các sự kiện cụ thể).

Tất cả các hệ thống nhận dạng sinh trắc học từ xa được coi là có rủi ro cao và phải tuân theo các yêu cầu nghiêm ngặt. Về nguyên tắc, việc sử dụng nhận dạng sinh trắc học từ xa ở những nơi công cộng cho mục đích thực thi pháp luật bị cấm.

Các trường hợp ngoại lệ được quy định chặt chẽ ví dụ, được phép sử dụng khi cần tìm kiếm một đứa trẻ mất tích, để ngăn chặn các mối đe dọa khủng bố cụ thể và sắp xảy ra, hoặc để phát hiện, xác định vị trí, xác định hoặc truy tố tội phạm hoặc tội phạm bị tình nghi. Việc sử dụng AI trong những trường hợp như vậy cần có sự cho phép của cơ quan tư pháp hoặc cơ quan độc lập khác và phải tuân theo các giới hạn thời gian thích hợp, phạm vi địa lý và cơ sở dữ liệu được tìm kiếm.

Rủi ro hạn chế

Rủi ro hạn chế đề cập đến các hệ thống AI có nghĩa vụ minh bạch nhất định. Với các hệ thống AI tạo sinh như ChatGPT và DALL-E có khả năng tạo ra văn bản, hình ảnh, mã hóa, âm thanh và các sản phẩm truyền thông khác…, dự luật yêu cầu các hệ thống AI này có nghĩa vụ minh bạch nhất định, chẳng hạn phải thông báo tới người dùng rằng đó là sản phẩm do máy móc tạo ra, không phải con người, để người dùng có thể đưa ra quyết định sáng suốt về việc tiếp tục hay rút lui.

Điều này có nghĩa là dự luật sẽ không cấm ChatGPT, nhưng các nhà phát triển nên tiết lộ chi tiết về công việc và kế hoạch tương lai của họ. Người dùng nên hiểu những rủi ro mà họ gặp phải nếu họ dựa vào độ tin cậy của thông tin nhận được từ chatbot.

Rủi ro tối thiểu hoặc không có rủi ro

Dự luật cho phép sử dụng AI trong nhóm các lĩnh vực được đánh giá là có rủi ro thấp, chẳng hạn các ứng dụng như trò chơi điện tử có AI hỗ trợ hoặc bộ lọc thư rác. Tuy nhiên, dự luật đưa ra các yêu cầu về tính minh bạch đối với các hệ thống trong loại này.